自 ChatGPT 面世以来,大模型步入了迅猛发展期 ,模型层出不穷 ,爆点频出 ,Al 技术的发展带动产业大规模升级的同时 ,也带来了对巨量算力和能源的需求 。

人工智能新纪元,算力为企业科技创新和转型提供有力支撑。在全球化的科技竞争格局中,领先的科技公司正积极部署千卡乃至超万卡规模的计算集群,既是展现其在人工智能、数据分析、大模型研发等前沿领域的技术实力,也向外界展示了公司对未来科技趋势的深远布局。整体而言,无论是通信运营商、头部互联网企业、大型 AI研发企业还是 AI 初创企业,都在通过自建或使用超万卡集群加速其在人工智能领域的技术突破和产业创新。随着超万卡集群建设的不断深入,我们预见这一趋势将为整个智算产业的发展带来深远影响。

在大算力结合大数据生成大模型的发展路径下,超万卡集群的搭建不是简简单单的算力堆叠,要让数万张 GPU 卡像一台“超级计算机”一样高效运转,超万卡集群的总体设计应遵循以下五大原则:坚持打造极致集群算力;坚持构建协同调优系统;坚持实现长稳可靠训练;坚持提供灵活算力供给;坚持推进绿色低碳发展。

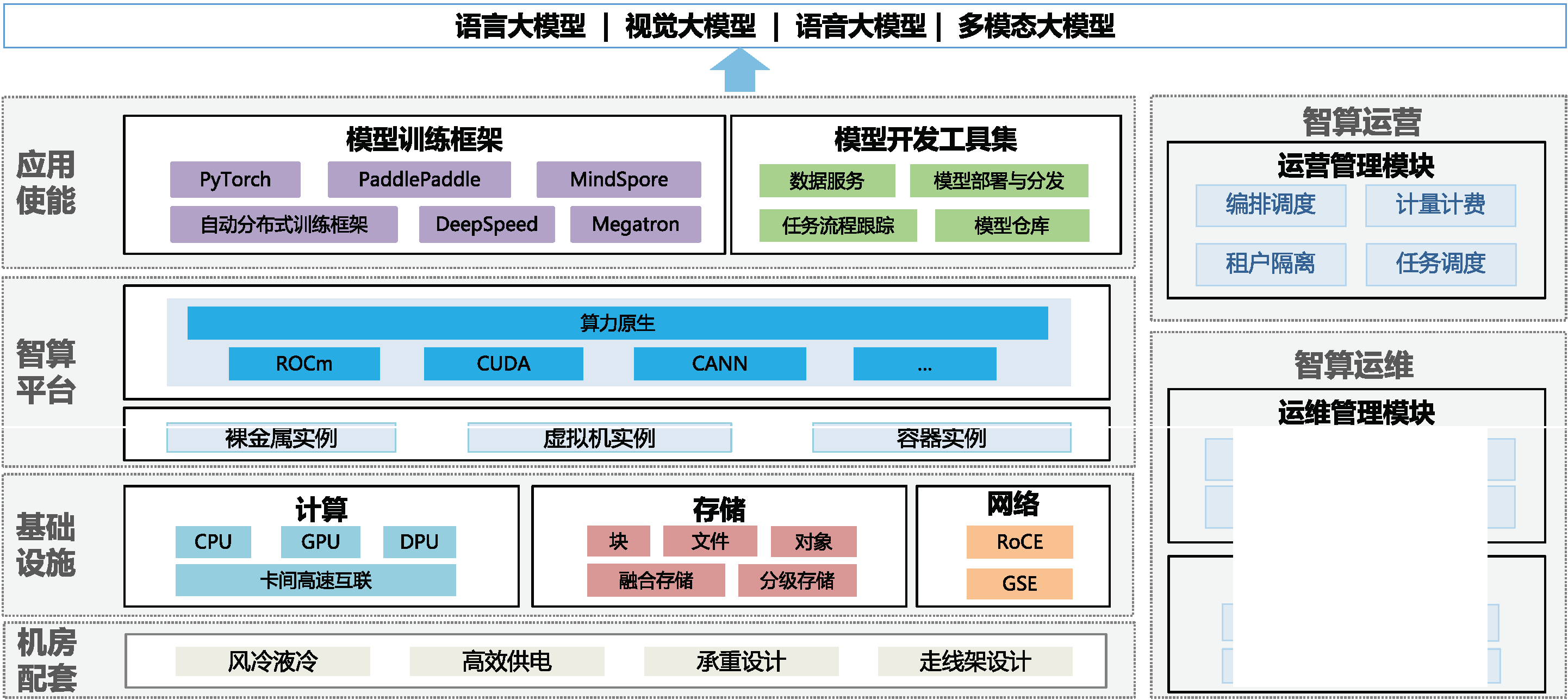

超万卡集群的总体架构由四层一域构成(如图 1),四层分别是机房配套、基础设施、智算平台和应用使能,一域是智算运营和运维域。

机房配套层:匹配超万卡集群高密集约的建设模式,机房配套设施需重点考虑高效供电、制冷设计、楼板承重和走线架设计等。

基础设施层:算、网、存三大硬件资源有机配合,达成集群算力最优。面向算力,CPU、GPU、DPU 三大芯片协同,最大化发挥集群计算能力,面向网络,参数面数据面、业务面、管理面独立组网,参数面/数据面采用大带宽 ROCE 交换和二层无阻塞 CLOS 组网满足大象流,支持参数面负载均衡和多租安全隔离;面向存储,引入融合存储和分级存储支持无阻塞数据并发访问。

智算平台层:采用 K8s,对上提供以裸金属和容器为主的集群资源。在对集群资源进行纳管的基础上,进一步实现大规模集群的自动化精准故障管理,以达成高效训练、长稳运行的目标。

应用使能层:包括模型训练框架和开发工具集两个模块,一方面基于现有开源框架能力,进行分布式训练调优,面向未来开展自动分布式训练框架设计,积累经验实现对通信和计算重叠的优化、算子融合以及网络性能的高效调优;另一方面,研发沉淀数据服务、模型部署开发等工具集,逐步实现由人工处理到基于工具对外提供自动化模型研发能力的转变。

智算运营和运维域:支持超万卡集群高效集合通信和调度。支持按租户灵活资源发放和任务调度,支持多任务并行训练。

RDMA 的通信方式和传统的TCP/IP不同,因此,智算高性能网络的运维管理也和之前的IP 网络的运维管理方式有所不同。具体来讲,RDMA 网络有如下特点:需要高精度的流量采集能力;更精细化的流量统计能力;全面的RDMA 流控指标的采集和统计;只有具备了上述基础的RDMA 网络业务可视化能力,才能更好地使用RDMA 网络,快速的发现和定位问题。

随着大模型从千亿参数的自然语言模型向万亿参数的多模态模型升级演进,超万卡集群亟需全面提升底层计算能力。具体而言,包括增强单芯片能力、提升超节点计算能力、基于 DPU(Data Processing Unit)实现多计算能力融合以及追求极致算力能效比。这些系统性的提升将共同支持更大规模的模型训练和推理任务,满足迅速增长的业务需求。

为了实现存储空间高效利用、数据高效流动,并支持智算集群大规模扩展,超万卡集群应采用多协议融合和自动分级存储技术,提升智算数据处理效率,助力超万卡集群支撑千亿乃至万亿大模型训练。

目前业界成熟的参数面主要包括lB(InfiniBand)和 ROCE 两种技术。

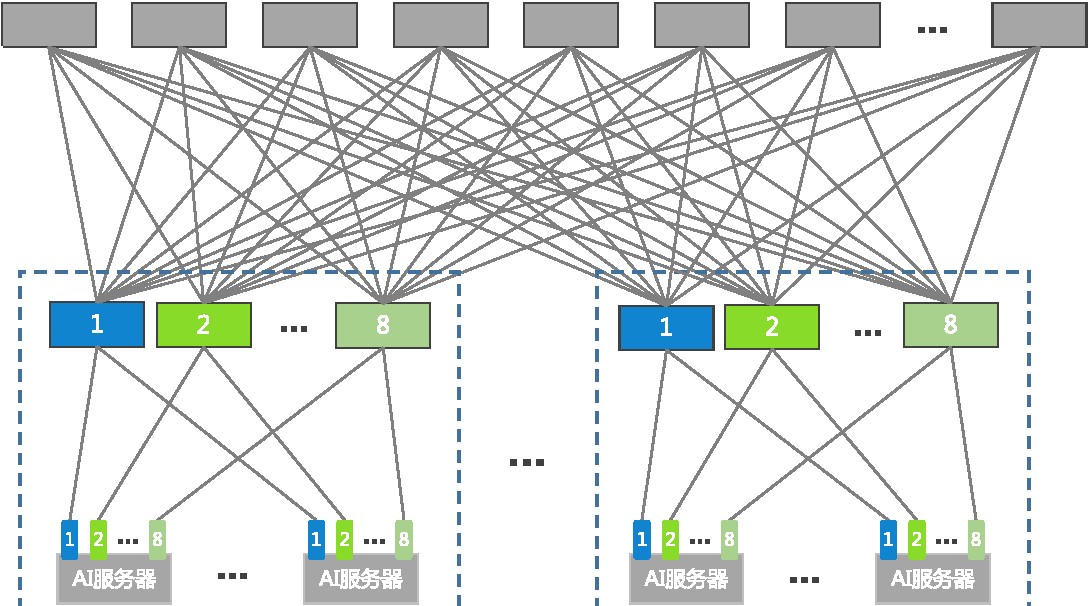

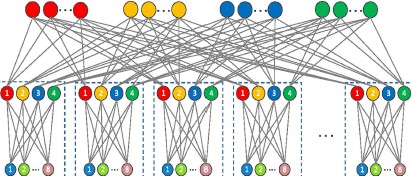

根据不同的 AI 服务器规模,参数面网络推荐采用 Spine-Leaf 两层组网或胖树(Fat-Tree)组网。

Spine-Leaf 两层组网如图 3 所示。每 8台 Leaf 交换机和下挂的 A| 服务器做为一个 group,以 group 为单位进行扩展。在 group 内部,推荐采用多轨方案将AI服务器连接至 Leaf 交换机,即所有 A|服务器的 1号网口都上连至 Leaf1,所有2 号网口上连至 Leaf2,依此类推,所有8号网口上连至 Leaf8。Spine 交换机和Leaf 交换机之间采用 Fullmesh 全连接。Leaf 交换机上下行收敛比为 1:1。

胖树(Fat-Tree)组网由 Leaf 交换机、Spine 交换机和 Core 交换机组成,如图所示。每8 台 Leaf 交换机和下挂的 A| 服务器做为一个 group,8 台 Leaf 交换4机又和上面 N 台 Spine 交换机组成一个 pod,胖树组网以 pod 为单位进行扩展。在胖树组网中,Spine 交换机和 Leaf 交换机之间采用 Fullmesh 全连接,所有Spine1 都 Full-Mesh 连接至第一组 Core,所有 Spine2 都 Full-Mesh 连接至第二组 Core,依次类推。Spine 交换机和 Leaf 交换机上下行收敛比都为 1:1。

分布式高性能应用的特点是“多打一”的 Incast 流量模型。对于以太交换机,Incast 流量易造成交换机内部队列缓存的瞬时突发拥塞甚至丢包,带来应用时延的增加和吞吐的下降,从而损害分布式应用的性能。A人工智能计算场景通常采用ROCEV2 协议与 DCOCN(Data Center Quantized Congestion Notification)拥塞控制机制相互配合实现零丢包无损网络。

AI 人工智能计算场景的流量特征是流数少、单流带宽大。传统的ECMP(EqualCost Multi Path)是基于5 元组的逐流 HASH,在流数少的时候极易出现 HASH 不均的情况,建议使用端口级负载均衡技术或算网协同负载均衡技术代替传统的ECMP。端口级负载均衡部署在 Leaf 交换机上,以源端口或目的端口作为数据流均衡的影响因子,在一个端口组内将归属于不同端口的数据流均衡到本地出端口集合上,消除传统基于五元组哈希的不确定性。

除此之外,还可以在参数网络里部署算网协同负载均衡技术,AI调度平台把任务信息通知给网络控制器,网络控制器结合已经建立的整网拓扑信息,进行整网最优转发路径计算,计算完成后自动生成路径并动态下发到网络设备,实现多任务全网负载均衡。使网络吞吐可以达到 95%以上,接近满吞吐。

超万卡集群中网络作为业务流量的调度中枢,其稳定性决定着整个集群的运行效率。在 A1场景里面,每次通信时间在毫秒级别,秒级时间内正常情况下已完成了多轮通信。如果依靠传统的路由收敛方式,将极大的影响 Al 计算效率。

DPFR(Data Plane Fast Recovery)技术在此场景下,可以做到毫秒级收敛,提供基于数据面的本地快收敛或远程快收敛。针对关键应用,尽量做到应用无感知的故障快速收敛效果,即在链路故障发生时业务性能无明显下降。

智算平台是智算中心承载模型训练、推理和部署的综合性平台系统,在智算中心技术体系架构中承担着重要的角色,对算力基础设施进行统一纳管、调度、分配和全生命周期管理,主要包含对计算、存储、网络等laaS 资源的云化管控,在此基础上通过云原生的容器底座能力,实现智算资源纳管分配、A任务作业调度、拓扑感知调度、训练全链路监控等满足智算业务的核心需求。

面向高密度高能耗智能算力发展,对于部署超万卡集群的新型智算中心来说,需要在确保智能计算设备安全、稳定、可靠地运行的前提下,具备高效制冷、弹性扩展、敏捷部署、绿色低碳等特征,并实现智能化运维管理。新型智算中心机房的关键要素如下:

随着数据规模的持续扩大、集群能力的不断增强以及大模型应用的日益丰富,对新型智算底座的升级提出了更高的要求。面对未来,我们呼吁在超节点、跨集群训练软件框架等领域实现技术突破,以强化智算基础设施能力。与此同时持续探索存算-体、光子芯片等先进技术领域与智算中心的结合,为下一次信息变革奠定基础。